UNA dam Jones, Ph.D.

UNA dam Jones, Ph.D.

En 2016, ProPublica causó revuelo cuando evaluó el rendimiento del software que se usa en la justicia penal actas. El software, que se usa para evaluar al acusado posibilidad de cometer más delitos, que resultó en producir resultados diferentes al evaluar a personas negras y caucásicas.

La importancia de esa discrepancia sigue siendo objeto de cierto debate, pero dos investigadores del Dartmouth College han pedido un pregunta más fundamental: ¿es bueno el software? La respuesta se les ocurrió “no es especialmente”, ya que su rendimiento podría ser emparejado reclutando personas en Mechanical Turk o realizando un análisis simple que solo tuvo en cuenta dos factores.

Software y sesgo

El software en cuestión se llama COMPAS , para Correccional Perfil de gestión de delincuentes para sanciones alternativas. Se necesita Tener en cuenta una amplia variedad de factores sobre los acusados y sus usos. para evaluar si es probable que esas personas se comprometan delitos adicionales y ayuda a identificar opciones de intervención. COMPASestá muy integrado en el proceso judicial (ver este documento del Departamento de Correcciones de California para tener una idea de su importancia). Quizás lo más significativo, sin embargo, a veces es influyente en la determinación de la sentencia, que puede basarse en el idea de que las personas que puedan cometer delitos adicionales deberían estar encarcelado por más tiempo.

La evaluación de ProPublica del software se centró en arrestos en Condado de Broward, Florida. Se encontró que el software tenía similar precisión a la hora de predecir si negro y caucásico los acusados volverían a ofender. Pero falsos positivos: casos en los que el software predijo otra ofensa que nunca sucedió, fueron dos veces tan probable como para involucrar a acusados negros. Los falsos negativos, donde se predijo que los acusados permanecerían libres de delitos, pero no lo hicieron, fueron el doble de probabilidades de involucrar a blancos.

Pero por otras medidas, el software no mostró indicios de sesgo (incluyendo, como se señaló anteriormente, su precisión general). Entonces el importancia de estos hallazgos ha seguido siendo un tema de debate.

Los investigadores de Dartmouth, Ja Dressel y Hany Farid, decidieron no para centrarse en el sesgo, sino en la precisión general. Para hacerlo, ellos tomó los registros de 1,000 acusados y extrajo su edad, sexo, e historial criminal. Estos se dividieron en grupos de 20, y Mechanical Turk se utilizó para reclutar personas a las que se les pidió que adivinaran la probabilidad de que cada uno de los 20 individuos se comprometa otro crimen en los próximos dos años.

Sabiduría de los turcos mecánicos

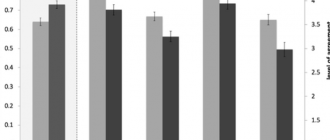

Al agrupar estos resultados, estas personas tenían una precisión media de 62 por ciento. Eso no está muy lejos de la precisión de COMPAS, que era 65 por ciento. En esta prueba, múltiples individuos evaluaron cada uno acusado, por lo que los autores agruparon estos y tomaron la mayoría opinión como una decisión. Esto llevó la precisión hasta el 67 por ciento, superando a COMPAS. Otras medidas de los mecánicos turcos la precisión sugería que eran tan buenos como el software.

Los resultados también fueron similares en el sentido de que no hubo diferencia entre sus evaluaciones de negro y caucásico acusados Lo mismo fue cierto cuando los autores presentaron una similar conjunto de registros para un nuevo conjunto de personas, pero esta vez incluido información sobre la raza del acusado. Entonces, en términos de general precisión, estas personas sin experiencia eran más o menos tan buenas como las software.

Pero también eran más o menos igual de malos, ya que también eran más propensos hacer falsos positivos cuando el acusado era negro, aunque no la misma extensión que COMPAS (una tasa de falsos positivos del 37 por ciento para Negros, en comparación con el 27 por ciento de los blancos). El falso negativo la tasa, donde se predijo que los acusados no volverían a ofender pero sí también mayor en caucásicos (40 por ciento) que en negros (29) por ciento). Esos números son notablemente similares a las tasas de Errores de COMPAS. Incluyendo datos de raza sobre los acusados no hizo un diferencia significativa.

Si el algoritmo pudiera coincidir con lo que es casi seguro grupo de aficionados, Dressel y Faridreasoned, tal vez sea porque no es especialmente bueno Entonces hicieron una serie de simples pruebas estadísticas (regresiones lineales) usando diferentes combinaciones de los datos que tenían sobre cada acusado. Descubrieron que podían igualar el rendimiento de COMPAS utilizando solo dos: la edad de la acusado y el recuento total de condenas anteriores.

Esto no es tan impactante como parece ser. Dressely Farid hacen gran parte de la afirmación de que COMPAS supuestamente considera 137 factores diferentes al hacer su predicción. Adeclaración de Equivant, la compañía que fabrica el software, señala que esos 137 son solo para evaluar intervenciones; La predicción de reincidencia solo utiliza seis factores. (El resto de la declaración se resume en “esto muestra que nuestro software es bastante bueno “.) Dressel y Farid también reconocen que volver a arrestar es un medida imperfecta de la actividad criminal futura, ya que algunos crímenes no dar lugar a arrestos, y hay importantes prejuicios raciales en tasas de arresto.

Qué hacer con todo esto se reduce a si eres cómodo tener un proceso que está mal aproximadamente un tercio del tiempo influyendo en cosas como cuánto tiempo pasan las personas en prisión. A Por el momento, sin embargo, no hay evidencia de nada más efectivo que eso.

Science Advances, 2017. DOI: 10.1126 / sciadv.aao5580 (Acerca de DOIs).